86.000 millones de razones o por qué la evolución sigue machacando a OpenAI

Cerebro vs IA: ¿Por qué somos más eficientes que los LLM? Analizamos energía, datos y evolución frente a OpenAI. Descubre el poder de tu mente.

CONCEPTOS CLAROS

Curiosidad Artificial con ayuda de Gemini

1/25/20264 min read

En las oficinas de Silicon Valley se habla de "Alineamiento", "Superinteligencia" y "Escalado". Parece que estamos a un paso de crear una mente digital que supere a la humana. Sin embargo, cuando bajamos al nivel de la ingeniería básica, la física, la termodinámica y la teoría del aprendizaje, la realidad es otra: los Modelos de Lenguaje Extensos (LLM) son, comparados con tu cerebro, asombrosamente ineficientes.

La evolución ha tenido 4.000 millones de años para optimizar cada julio de energía. Nosotros llevamos apenas una década intentando imitarla con cables. Y las diferencias no son solo de matiz; son abismos estructurales.

El becario que nunca aprende: cuando la IA te deja mentalmente KO

Usar la IA generativa no es delegar y relajarse; es asumir un nuevo rol: el de supervisor a tiempo completo de un becario increíblemente rápido, productivo, complaciente... y con amnesia crónica. Ese trabajo de supervisión constante, sin la recompensa del aprendizaje a largo plazo, podría ser la nueva fuente de fatiga cognitiva.

También publicado en Curiosidad Artificial

★★★★★

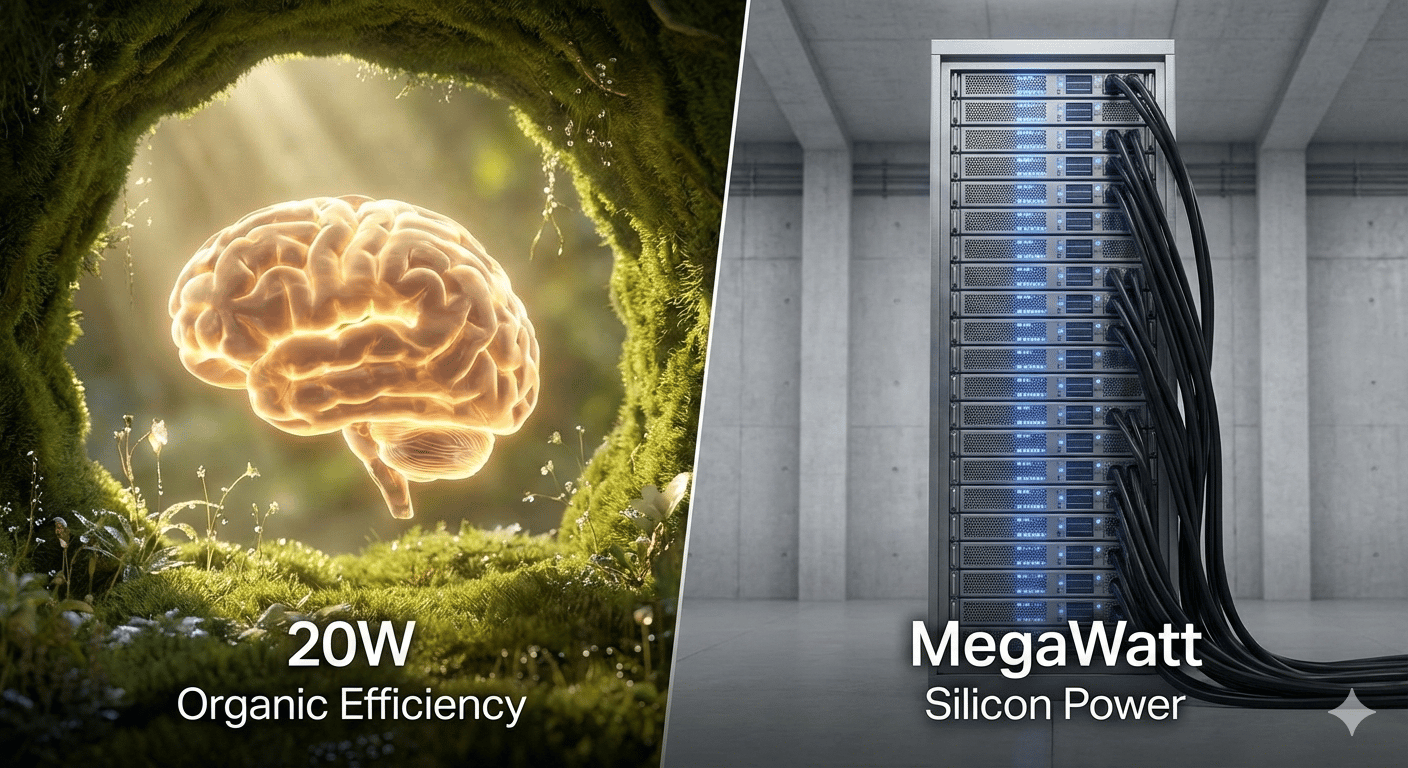

La bombilla vs. el centro de datos

Empecemos por el dato que debería darnos humildad: tu cerebro funciona con unos 20 vatios. Es la potencia de una bombilla LED pequeña o de la luz de tu nevera. Con esa energía, eres capaz de conducir un coche, mantener una conversación filosófica, sentir empatía y recordar el olor de un postre que comiste en un remoto lugar mientras compartías tiempo de calidad con amigos hace años.

Para que GPT-4 o GPT-5 puedan responderte qué cenar hoy, necesitan centros de datos que consumen megavatios. Una sola tarjeta gráfica de última generación (como las de Nvidia) consume 700W por sí sola, y se necesitan miles trabajando en paralelo. En términos de eficiencia energética, el silicio es un gigante glotón frente al cerebro, que es un atleta de élite alimentado por un simple plato de pasta.

El problema del "Internet Slop" y la generalización

Aquí reside uno de los mayores retos de la IA actual. Un LLM es un "devorador de datos". Para aprender a identificar un gato o escribir un código, necesita haber procesado billones de palabras e imágenes de Internet. Pero Internet se está llenando de "slop": contenido basura generado por otras IAs, errores y datos de baja calidad.

El cerebro humano, en cambio, es el rey de la generalización con pocos ejemplos. Un niño de dos años ve un perro tres veces y ya es capaz de identificar a cualquier perro del mundo, aunque sea de una raza que nunca ha visto o esté dibujado en una pared. La IA necesita miles de fotos etiquetadas. ¿Por qué? Porque el cerebro no solo busca patrones estadísticos; construye un modelo del mundo.

Para superar este muro, las empresas de IA están recurriendo a los datos sintéticos: datos de alta calidad generados por modelos para entrenar a otros modelos en áreas como las matemáticas o la lógica, donde la verdad es objetiva. Es un intento desesperado de fabricar "comida de calidad" para la IA porque el Internet real empieza a estar contaminado. Y ya estamos viendo las consecuencias de esta línea de desarrollo, modelos que obtienen grandes mejoras en programación o en resolución de problemas matemáticos, pero que en habilidades como la comprensión del lenguaje o la escritura apenas hay diferencias respecto de los modelos anteriores.

Conocimiento congelado vs. aprendizaje eterno

Imagina que tu cerebro se detuviera el día que terminaste el instituto y nunca pudieras aprender nada nuevo, solo repetir lo que ya sabes. Eso es, esencialmente, un LLM. En la IA existe una separación radical entre el entrenamiento (donde el modelo aprende) y la inferencia (donde el modelo responde). Una vez que el modelo sale de la "fábrica" de entrenamiento, su conocimiento está congelado. Si le preguntas por algo que ocurrió ayer y no está en su ventana de contexto, no lo sabe porque no puede integrar información nueva de forma dinámica en su estructura.

Tú, en cambio, estás en modo "entrenamiento" las 24 horas del día. Cada interacción, cada error y cada nueva noticia modifica físicamente tus conexiones sinápticas. El cerebro es un sistema plástico; la IA es una base de datos estática que simula fluidez.

El cerebro en streaming: sensores vs. texto

Por último, debemos hablar de la desconexión total del LLM con la realidad. Un modelo de IA vive en una caja de cristal oscura. Su única ventana al mundo es el texto (o imágenes) que le inyectamos. No sabe qué es el "calor" porque nunca lo ha sentido; solo sabe que la palabra "calor" suele aparecer cerca de la palabra "sol".

El ser humano es un sistema de streaming constante. Tenemos sensores de serie: la piel nos informa de la presión y la temperatura; los ojos nos dan una señal de vídeo en 4K y 3D en tiempo real; el oído, el olfato y el gusto completan un cuadro de datos que no solo nos permite "saber", sino "experimentar".

Esta falta de comprensión del mundo físico es lo que provoca las famosas "alucinaciones". La IA no entiende que una vaca no puede volar porque no sabe qué es la gravedad ni qué es una vaca; solo sabe que, estadísticamente, la frase "las vacas vuelan" es poco probable.

El camino por delante

¿Significa esto que la IA nunca nos alcanzará? No necesariamente, pero los retos son monumentales. Para aproximarse al cerebro, la IA del futuro tendrá que:

Aprender de forma continua sin tener que reiniciar su entrenamiento.

Ser multimodal nativa, recibiendo datos de sensores físicos (robótica).

Reducir su consumo de forma drástica para no devorar la red eléctrica del planeta.

Mientras tanto, la próxima vez que te sientas abrumado por la tecnología, recuerda: llevas en tu cabeza el sistema de computación más sofisticado, eficiente y misterioso del universo conocido. Y funciona con menos energía que la lámpara de tu mesita de noche.

Sígueme

Conectando tecnología y vida cotidiana de forma sencilla.

Sigue explorando con Curiosidad Artificial